本人確認システムでは、ユーザーの写真と ID を照合することで、エンドユーザーの本人確認をリモートでオンラインで保証するために AI がますます使用されています。しかし、これらのソリューションが不公平または偏った方法で実装されると、企業はユーザーを保護するのではなく、害を及ぼすリスクを負い、結果として大きな損失、規制上の措置、またはブランドのダメージを被る可能性があります。意思決定アルゴリズムによるこのような体系的な差別は AI バイアスとして知られており、本人確認システムではよく見られる現象です。これらのアルゴリズムは拡張性を考慮して設計されており、金融機関、医療提供者、モバイル通信事業者、その他重要なサービスを提供する企業で使用されているため、すべての人にとって機能するシステムを実装することがさらに重要になります。このブログ投稿は、意思決定者が AI バイアス、ID 証明システムにおける AI バイアスの原因、および Transmit Security が ID 検証サービスにおけるバイアスを軽減する方法を理解するのに役立つように設計されています。

AIバイアスを理解する

すべての AI システムはバイアスの影響を受けます。問題は、そのバイアスによって、特定の年齢層、人種、性別などの特定の人口統計に対してモデルが不公平または不正確な決定を下す傾向がある場合に発生します。これは、AI システムがトレーニング データに基づいて意思決定を行うことを学習し、そのデータの品質が、データを選択して分析する人間の歴史的または社会的不平等や偏見によって影響を受ける可能性があるためです。これは、 ゴミを入れればゴミが出る 機械学習の格言: 偏ったデータは偏った意思決定につながり、最終的には過小評価されたグループの間でエラー率が著しく高いモデルが生まれます。また、AI モデルは多くの場合、決定に至った要因を説明しないブラック ボックスであるため、こうした偏見は長期間にわたって気付かれず、チェックされないままになり、少数派の人々を差別する既存のポリシーが拡大され、成文化される可能性があります。

本人確認システムにおける AI バイアスの原因は何ですか?

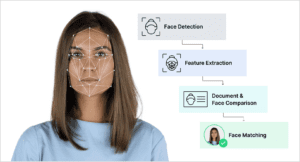

本人確認は通常、2 段階のプロセスです。まず、ユーザーは自分の身分証明書の写真を撮影します。この写真を使ってデータが抽出され、偽造や改ざんの兆候がないかチェックされます。次に、ユーザーが提示した自撮り写真が分析され、ユーザー本人であること、また身分証明書に記載されている人物と同一人物であるかどうかが確認されます。これらの画像を比較するために、顔の対称性、肌の色合いや質感、顔の特徴の測定値、顔のさまざまな部分の形状などのパラメータがID写真から抽出され、デジタル署名の作成に使用され、ユーザーの自撮り写真の署名と比較されます。

ただし、一部の機能は他の機能よりも正確な結果を生成する可能性があり、分析しようとするデータ ポイントが多すぎると、ノイズの中でパターンを検出するのが難しくなる可能性があります。さらに、代表性の低いグループに対する十分なトレーニング データが不足すると、モデルがこれらのグループの顔を正確に区別するために必要な特徴を無視したり、重要度を低くしたりする可能性があります。その結果、データ サイエンティストは、モデルが効果的で偏りのない結果を生み出す可能性が最も高い特徴に焦点を当てていることを確認する必要があります。これは特徴選択と呼ばれるプロセスです。歴史的および制度的な偏見により、特定の人口統計に対して本人確認の結果が歪む可能性もあります。たとえば、デジタル カメラのセンサーは、顔の画像を定義するために明るさに合わせて調整されることが多く、肌の色が濃い被写体に対しては効果が低くなります。顔検出アルゴリズムが目、頬、鼻などの特徴間のコントラストの強さを捉えて顔を区別する場合、この傾向はさらに強まります。

Transmit Security は AI バイアスのリスクをどのように軽減しますか?

Transmit Security は、公平な AI システムの開発において最高水準を維持し、モデルの選択から展開、生産に至るまで、AI ライフサイクル全体にわたって偏見を監視および軽減するための措置を講じています。私たちが使用している対策には次のようなものがあります:

- ディープラーニングアーキテクチャ: 私たちは最先端のマルチタスク畳み込みニューラル ネットワークを使用しています。このネットワークは 3 つのカスケード モデルを使用して、顔の検出と分析に使用する顔のランドマークの選択を改善します。

- 多様なデータセット: 当社のモデルは、バランスのとれた多様なユーザー グループからのラベル付きデータを使用して、Pilot Parliaments Benchmark などの偏見に対処するために設計された複数の公開データセットを含む 400,000 を超える画像でトレーニングされます。

- データサンプリング: 私たちは、データセットのバランスをとるために、層別サンプリングなどのデータ サンプリング手法を使用します。層別サンプリングでは、同じ人口統計内のユーザーのサブグループに母集団を分割し、比例した数のサンプルを選択してモデルをトレーニングし、データ サンプルが少ないグループが適切に考慮されるようにします。

- 監視と検証: モデルをテストした後、人種、性別、年齢層ごとに誤検知と誤検知の数を分類し、ベンチマーク データセットと比較して結果を評価します。この監視はモデルのライフサイクル全体にわたって継続されるため、導入されたバイアスを迅速に検出し、必要に応じて修正手法を適用できます。

- モデルの説明可能性: 私たちは、顔照合における AI の偏りによる失敗と、ユーザーのエラーやその他のリスク シグナルによる失敗を区別するのに役立つ、正確で人間が読める説明を使用して、それぞれの拒否または異議申し立ての推奨の理由を透明化します。

結論

重要なサービスへのオンライン アクセスはユーザーにとって必要不可欠なものになりつつあり、ID チェックによる安全なデジタル オンボーディングがこれまで以上に重要になっています。しかし、AI は企業向けにこれらの重要なサービスを拡大する鍵を握っていますが、ベンダーと企業には、これらの決定が公正かつ公平であることを保証する責任があり、同時に既存の偏見や差別を拡大しないようにする必要があります。当社の このブログ投稿では、ID 検証サービスによってユーザーの安全なオンボーディングが可能になる方法を説明しています。また、営業担当者に連絡して、無料のパーソナライズされたデモを設定することもできます。